Table des matières:

- Auteur John Day day@howwhatproduce.com.

- Public 2024-01-30 09:06.

- Dernière modifié 2025-01-23 14:45.

L'objectif de l'instructable est de développer un guide de marche qui peut être utilisé par les personnes handicapées, en particulier les malvoyants. L'instructable a l'intention d'étudier comment le guide de marche peut être utilisé efficacement, afin que les exigences de conception pour le développement de ce guide de marche puissent être formulées. Pour atteindre l'objectif, cette instructable a les objectifs spécifiques suivants.

- Concevoir et mettre en œuvre le prototype de lunettes pour guider les personnes malvoyantes

- Développer un guide de marche pour réduire les collisions avec des obstacles pour les personnes malvoyantes

- Développer une méthode de détection des nids-de-poule sur la surface de la route

Trois capteurs de mesure de distance (capteur à ultrasons) sont utilisés dans le guide de marche afin de détecter l'obstacle dans chaque direction, y compris l'avant, la gauche et la droite. De plus, le système détecte les nids-de-poule sur la surface de la route à l'aide d'un capteur et d'un réseau de neurones convolutifs (CNN). Le coût global de notre prototype développé est d'environ 140 $ et le poids est d'environ 360 g, y compris tous les composants électroniques. Les composants utilisés pour le prototype sont des composants imprimés en 3D, un raspberry pi, une caméra raspberry pi, un capteur à ultrasons, etc.

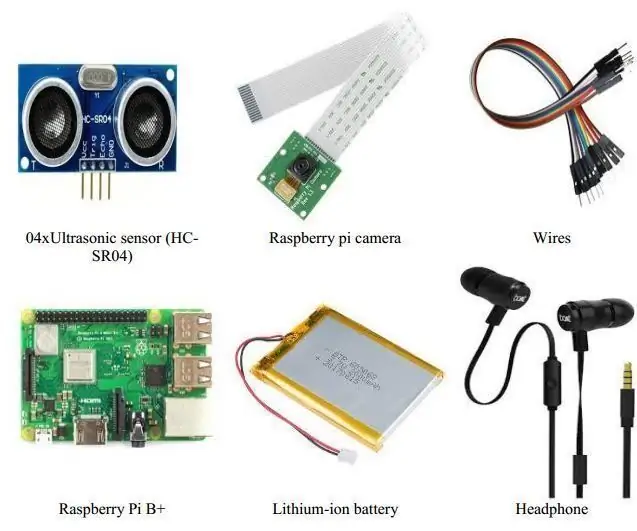

Étape 1: Matériel nécessaire

-

Pièces imprimées en 3D

- 1 x temple gauche imprimé en 3D

- 1 x temple droit imprimé en 3D

- 1 x cadre principal imprimé en 3D

-

Pièces électroniques et mécaniques

- 04 x Capteur à ultrasons (HC-SR04)

- Raspberry Pi B+ (https://www.raspberrypi.org/products/raspberry-pi-3-model-b-plus/)

- Appareil photo Raspberry pi (https://www.raspberrypi.org/products/camera-module-v2/)Batterie lithium-ion

- Fils

- casque de musique

-

Outils

- Colle chaude

- Ceinture en caoutchouc (https://www.amazon.com/Belts-Rubber-Power-Transmis…

Étape 2: Pièces imprimées en 3D

Le prototype de lunettes est modélisé dans SolidWorks (modèle 3D) en tenant compte de la dimension de chaque composant électronique. Dans la modélisation, le capteur à ultrasons avant est positionné dans la lunette pour détecter uniquement les obstacles avant, les capteurs à ultrasons gauche et droit sont réglés à 45 degrés du point central de la lunette afin de détecter les obstacles dans l'épaule et le bras de l'utilisateur; un autre capteur à ultrasons est positionné vers le sol pour la détection de nid-de-poule. La caméra Rpi est positionnée au centre du spectacle. De plus, les branches droite et gauche de la lunette sont conçues pour positionner respectivement le raspberry pi et la batterie. Les pièces imprimées SolidWorks et 3D sont affichées sous différentes vues.

Nous avons utilisé une imprimante 3D pour développer le modèle 3D du spectacle. L'imprimante 3D peut développer un prototype jusqu'à une taille maximale de 34,2 x 50,5 x 68,8 (L x l x H) cm. En plus de cela, le matériau qui est utilisé pour développer le modèle de la lunette est un filament d'acide polylactique (PLA) et il est facile à obtenir et peu coûteux. Toutes les pièces du spectacle sont produites en interne et le processus d'assemblage peut être facilement effectué. Afin de développer le modèle du spectacle, la quantité de PLA avec matériau de support est nécessaire d'environ 254 g.

Étape 3: Assemblage des composants

Tous les composants sont assemblés.

- Insérez le raspberry pi dans la tempe droite imprimée en 3D

- Insérez la batterie dans la tempe gauche imprimée en 3D

- Insérez la caméra à l'avant du cadre principal où le trou est créé pour la caméra

- Insérez le capteur à ultrasons dans le trou spécifié

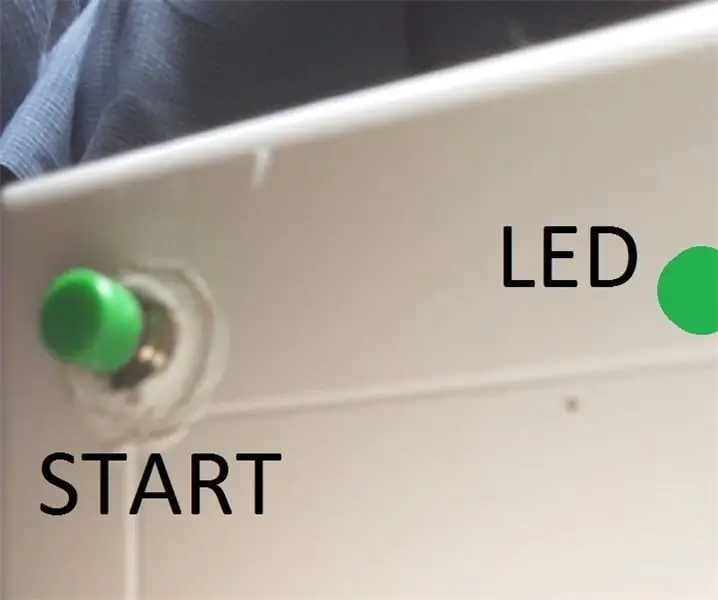

Étape 4: Connexions matérielles

La connexion de chaque composant est mappée avec le raspberry pi et montré que la broche de déclenchement et d'écho du capteur avant est connectée aux broches GPIO8 et GPIO7 du raspberry pi. Les GPIO14 et GPIO15 connectent le déclencheur et la broche d'écho du capteur de détection de nids-de-poule. La batterie et le casque sont connectés à l'alimentation micro USB et au port jack audio du raspberry pi.

Étape 5: Prototype utilisateur

Un enfant aveugle porte le prototype et se sent heureux de marcher dans l'environnement sans aucune collision avec des obstacles. L'ensemble du système donne une bonne expérience lors des tests avec des malvoyants.

Étape 6: Conclusion et plan futur

L'objectif principal de cette instructable est de développer un guide de marche pour aider les personnes malvoyantes à naviguer de manière indépendante dans des environnements. Le système de détection d'obstacles vise à indiquer la présence d'obstacles aux alentours dans les directions avant, gauche et droite. Le système de détection de nids-de-poule détecte les nids-de-poule sur la surface de la route. Le capteur à ultrasons et la caméra Rpi sont utilisés pour capturer l'environnement réel du guide de marche développé. La distance entre l'obstacle et l'utilisateur est calculée en analysant les données des capteurs à ultrasons. Les images de nids-de-poule sont initialement formées à l'aide d'un réseau de neurones convolutifs et les nids-de-poule sont détectés en capturant une seule image à chaque fois. Ensuite, le prototype du guide de marche est développé avec succès avec un poids d'environ 360 g, y compris tous les composants électroniques. La notification aux utilisateurs est fournie avec la présence d'obstacles et de nids-de-poule grâce à des signaux audio par casque.

Sur la base des travaux théoriques et expérimentaux effectués au cours de cette instructable, il est recommandé que des recherches supplémentaires puissent être effectuées pour améliorer l'efficacité du guide de marche en abordant les points suivants.

- Le guide de marche développé est devenu légèrement encombrant en raison de l'utilisation de plusieurs composants électroniques. Par exemple, le raspberry pi est utilisé mais toutes les fonctionnalités du raspberry pi ne sont pas utilisées ici. Par conséquent, le développement d'un circuit intégré spécifique à l'application (ASIC) avec les fonctionnalités du guide de marche développé peut réduire la taille, le poids et le coût du prototype

- Dans l'environnement du monde réel, certains obstacles critiques auxquels sont confrontées les personnes malvoyantes sont les bosses sur la surface de la route, la situation des escaliers, la douceur de la surface de la route, l'eau sur la surface de la route, etc. Cependant, le guide de marche développé ne détecte que les nids-de-poule sur la route surface. Ainsi, l'amélioration du guide de marche compte tenu d'autres obstacles critiques peut contribuer à la poursuite des recherches pour aider les personnes malvoyantes

- Le système peut détecter la présence d'obstacles mais ne peut pas catégoriser les obstacles, indispensables pour les personnes malvoyantes en navigation. La segmentation sémantique au niveau des pixels de l'environnement peut contribuer à catégoriser les obstacles autour de l'environnement.

Conseillé:

Stop ALICE - Barricade de porte pour Particuliers à Mobilité Réduite : 8 Étapes

Stop ALICE - Barricade de porte pour personnes à mobilité réduite : le problèmePour les personnes qui utilisent des fauteuils roulants, il peut être difficile de se barricader dans une pièce en cas de besoin. L'objectif de ce projet est de concevoir un dispositif pour aider les personnes qui utilisent des fauteuils roulants et/ou ont une force réduite des bras rapidement barr

ESP8266 - Prise temporisée et télécommandée (sécurité des personnes âgées) : 6 étapes

ESP8266 - Prise temporisée et télécommandée (sécurité personnes âgées) : INFORMATION : Ce montage est un contrôle contre la surchauffe, l'incendie et les accidents en cas d'oubli d'appareils connectés (principalement par des personnes âgées atteintes d'Alzheimer). Après le déclenchement du bouton, la prise reçoit 110/220 VAC pendant 5 minutes (un autre

Expérience de bus améliorée pour les personnes malvoyantes avec Arduino et impression 3D : 7 étapes

Expérience de bus améliorée pour les personnes malvoyantes avec Arduino et l'impression 3D : comment simplifier les déplacements dans les transports en commun pour les personnes malvoyantes ? Les données en temps réel sur les services cartographiques sont souvent peu fiables lorsque vous utilisez les transports en commun. personnes déficientes visuelles. T

Appareil à ultrasons pour améliorer la navigation des malvoyants : 4 étapes (avec photos)

Appareil à ultrasons pour améliorer la navigation des malvoyants : nos pensées vont aux personnes défavorisées alors que nous utilisons nos talents pour améliorer la technologie et rechercher des solutions pour améliorer la vie des personnes souffrantes. Ce projet a été uniquement créé dans ce but. Ce gant électronique utilise la détection par ultrasons pour améliorer

Réparer un vieux haut-parleur : un guide de bricolage pour améliorer votre chaîne stéréo domestique : 7 étapes

Réparer une vieille enceinte : un guide de bricolage pour améliorer votre chaîne stéréo : vous voulez une nouvelle paire d'enceintes audio pour la maison mais vous ne pouvez pas vous permettre de dépenser des centaines d'euros ? Alors pourquoi ne pas réparer vous-même une vieille enceinte pour aussi peu que 30 $ !? Remplacement d'un pilote de haut-parleur est un processus facile, que vous ayez un haut-parleur grillé