Table des matières:

- Auteur John Day day@howwhatproduce.com.

- Public 2024-01-30 09:07.

- Dernière modifié 2025-01-23 14:45.

Pour les malvoyants, utilisez-le pour mieux comprendre le monde qui vous entoure.

Fournitures

Objets utilisés dans ce projet

Composants matériels Walabot Creator ×1

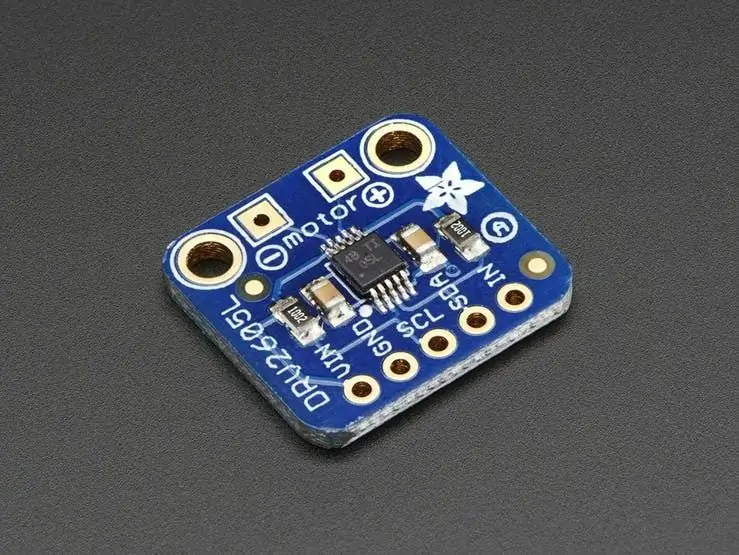

CONTRLEUR DE MOTEUR HAPTIQUE ADAFRUIT DRV2605L × 1

Raspberry Pi 3 modèle B × 1

MINI DISQUE MOTEUR VIBRANT Adafruit ×1

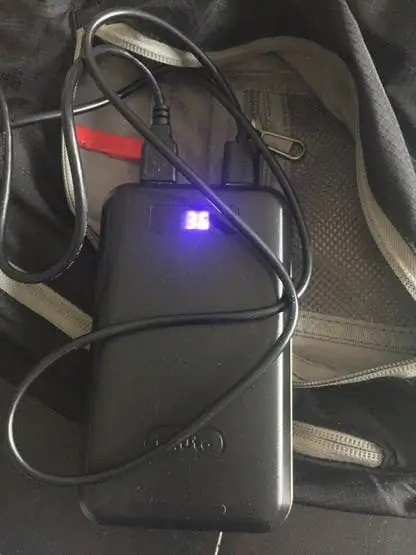

Batterie 5.1V × 1

sac à dos × 1

Cavaliers (génériques) ×5

Étape 1: Résumé

Comment serait-ce si vous pouviez sentir les objets autour de vous ? Cela signifie que vous pourriez naviguer dans l'espace même si votre vision était compromise ? Non seulement pour les personnes malvoyantes, cette idée pourrait également être utilisée par les services d'urgence (notamment les pompiers) dans des environnements enfumés. L'audio n'est pas toujours le moyen le meilleur et le plus discret de donner des instructions, le retour haptique, en revanche, sera parfait.

Étape 2: L'idée de base

Je voulais créer un capteur capable de détecter les obstacles, puis de conseiller le porteur à l'aide d'un retour haptique à quelle distance se trouve l'objet et s'il vient de la gauche, de la droite ou tout droit devant. Pour cela, j'aurai besoin de: Un capteur capable de voir l'espace 3DLe pilote de retour haptiqueUn actionneur de retour haptiqueUne batterie externeUn sac à dos auquel il peut être attaché.

Étape 3: Walabot

Vous voulez voir à travers les murs ? Détecter des objets dans l'espace 3D ? Sentez-vous si vous respirez de l'autre côté de la pièce ? Eh bien, vous avez de la chance.

Le Walabot est une toute nouvelle façon de détecter l'espace autour de vous à l'aide d'un radar à faible puissance. Cela allait être la clé de ce projet. Je serais capable de prendre les coordonnées cartésiennes (X-Y-Z) des objets dans l'espace 3D, celles-ci seront mappées à une série de retours haptiques pour donner au porteur une meilleure compréhension de l'espace qui les entoure.

Étape 4: Commencer

Tout d'abord, vous aurez besoin d'un ordinateur pour piloter le Walabot. Pour ce projet, j'utilise un Raspberry Pi 3 (ci-après appelé RPi) en raison du WiFi intégré et du punch supplémentaire général.

J'ai acheté une carte SD de 16 Go avec NOOBS préinstallé pour que les choses restent simples et agréables, et j'ai choisi d'installer Raspian comme système d'exploitation Linux de choix (si vous ne savez pas comment installer Raspian, veuillez prendre un moment pour en lire un peu) OK, une fois que vous avez exécuté Raspian sur votre RPi, il y a quelques étapes de configuration à suivre pour préparer les choses pour notre projet. Tout d'abord, assurez-vous que vous exécutez la dernière version du noyau et vérifiez les mises à jour en ouvrant un shell de commande et en tapant:

sudo apt-get mise à jour

sudo apt-get dist-upgrade

(Sudo est ajouté pour vous assurer que vous avez des privilèges administratifs, par exemple, les choses fonctionneront.) Cela peut prendre un certain temps, alors allez prendre une bonne tasse de thé. 2.

Vous devez installer le SDK Walabot pour RPi. À partir de votre navigateur Web RPi, accédez à https://www.walabot.com/gettingstarted et téléchargez le package d'installation de Raspberry Pi.

Depuis un shell de commande:

téléchargements de CD

sudo dpkg -I walabotSDK_RasbPi.deb

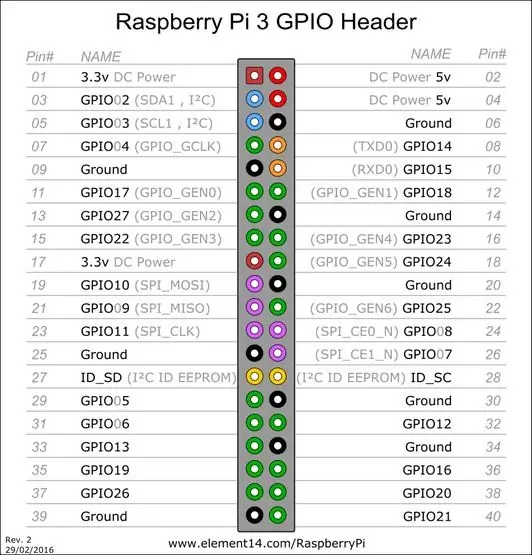

Nous devons commencer à configurer le RPi pour utiliser le bus i2c. Depuis un shell de commande:

sudo apt-get installer python-smbus

sudo apt-get install i2c-tools

Une fois cela fait, vous devez ajouter ce qui suit au fichier modules.

Depuis un shell de commande:

sudo nano /etc/modules

ajoutez ces 2 chaînes sur des lignes séparées

i2c-dev

i2c-bcm2708

Le Walabot consomme pas mal de courant, et nous utiliserons également des GPIO pour contrôler les choses, nous devons donc les configurer.

Depuis un shell de commande:

sudo nano /boot/config.txt

ajoutez les lignes suivantes à la fin du fichier:

safe_mode_gpio=4

max_usb_current=1

Le RPi est un excellent outil pour les makers, mais il est limité dans le courant qu'il peut envoyer au Walabot. C'est pourquoi nous ajoutons un courant maximum de 1Amp plutôt que le 500mA plus standard.

Étape 5: Python

Pourquoi Python ? Eh bien, comme c'est super facile à coder, rapide à démarrer, et il y a plein de bons exemples python disponibles ! Je ne l'avais jamais utilisé auparavant et j'étais bientôt opérationnel en un rien de temps. Maintenant que le RPi est configuré pour ce que nous voulons, la prochaine étape consiste à configurer Python pour avoir accès à l'API Walabot, aux interfaces LCD Servo.

Pour le Walabot

Depuis un shell de commande:

Sudo pip install "/usr/share/walabot/python/WalabotAPI-1.0.21.zip"

Pour le pilote haptique

Depuis un shell de commande:

sudo apt-get install git build-essential python-dev

disque ~

clone git

La carte pilote haptique Adafruit DRV2605 est excellente car vous pouvez envoyer des signaux I2C pour déclencher des tonnes de profils haptiques enregistrés. Le seul inconvénient était qu'il n'y avait pas de bibliothèque Python disponible pour cela. Mais n'ayez crainte ! J'en ai écrit un dans le cadre de ce projet.

Étape 6: Exécution automatique du script

Maintenant que tout est configuré et configuré, et que le code Python est prêt, nous pouvons configurer les choses pour qu'elles s'exécutent automatiquement afin de pouvoir abandonner le clavier et les moniteurs.

Il y a quelques choses à faire:

Créez un nouveau fichier de script pour exécuter le programme Python

sudo nano walaboteye.sh

Ajouter ces lignes

#!/bin/sh

python /home/pi/WalabotEyeCLI.py

Assurez-vous de l'enregistrer. Ensuite, nous devons autoriser le script à s'exécuter en tapant:

Sudo chmod +x /home/pi/walaboteye.sh

Et enfin, nous devons ajouter ce script au fichier /etc/rc.local

Sudo nano /etc/rc.local Ajouter home/pi/walaboteye.sh &

Assurez-vous d'inclure le "&". Cela permet au script Python de s'exécuter en arrière-plan. C'est toute la configuration et les logiciels triés, il est ensuite temps de câbler le matériel.

Étape 7: le matériel

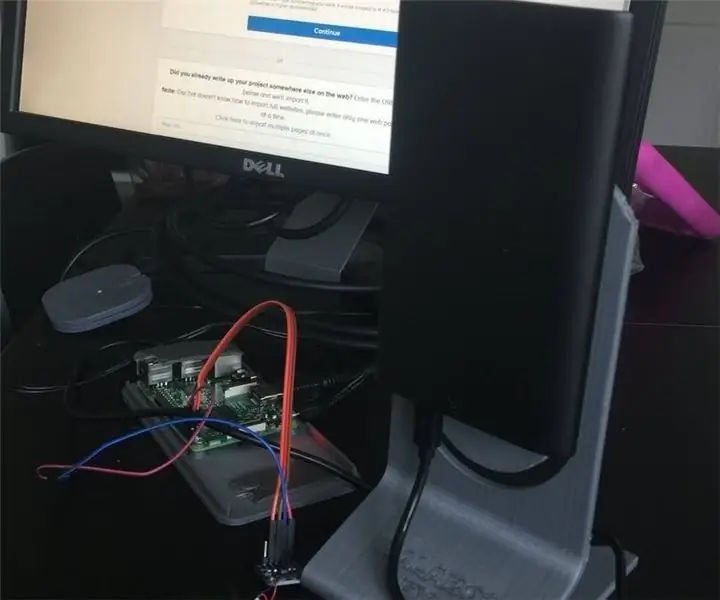

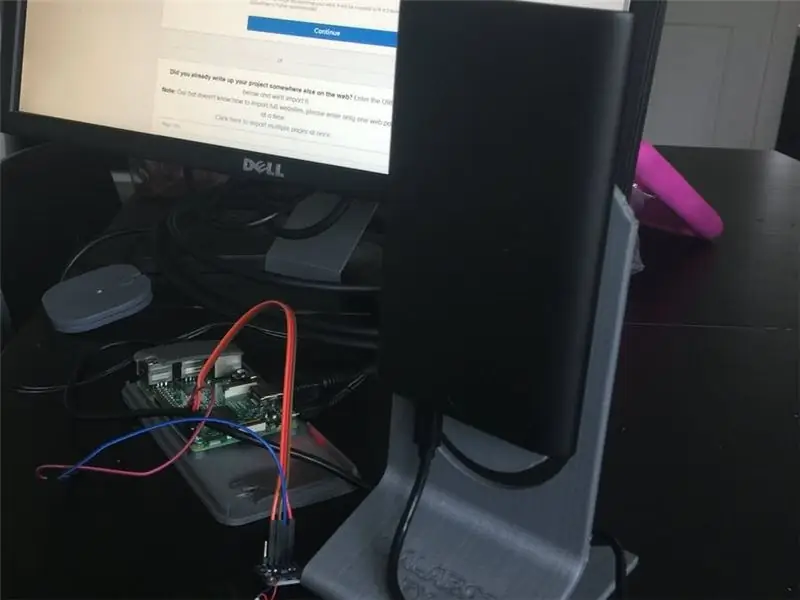

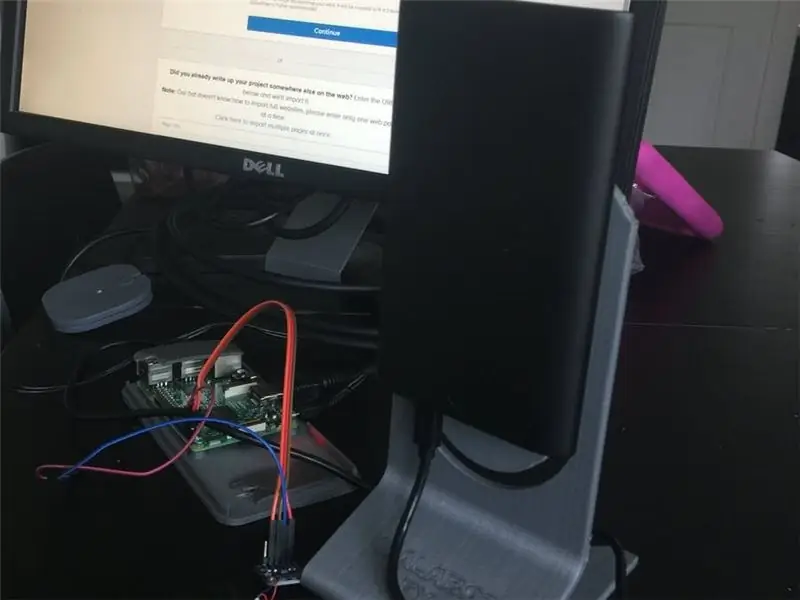

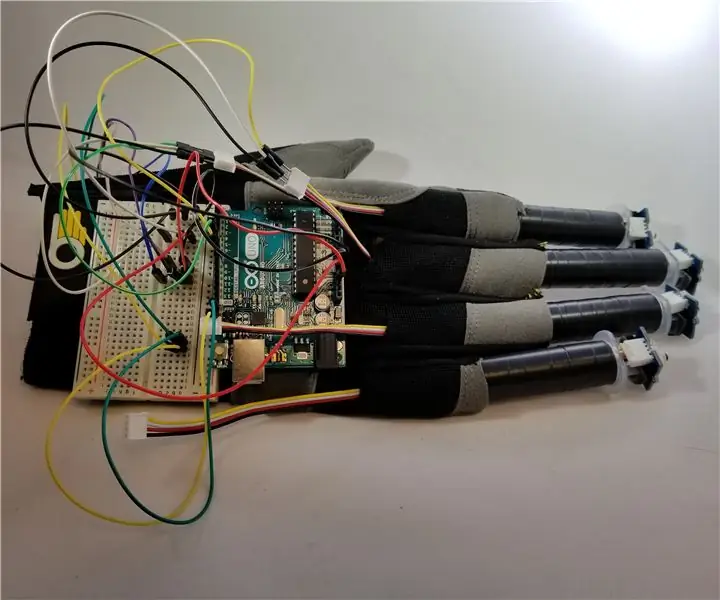

Ce n'est pas ma meilleure heure, mais je me sens délicieusement hacky ! Comme vous le verrez sur les images.

Étape 8:

Le câblage est super simple. Connectez les broches RPi, SDA SCL VCC et GND aux broches correspondantes du DRV2605. Connectez votre moteur haptique à la carte de commande… c'est tout pour cette partie !

Étape 9:

Après cela, tout ce que vous avez à faire est de connecter le walabot USB au RPi et d'obtenir votre meilleur ruban adhésif, et de tout fixer en place comme indiqué:

Étape 10: Comment ça marche

L'idée est très simple. Selon la distance à laquelle se trouve l'obstacle, la force du bourdonnement se fera sentir sur votre épaule. 2 mètres plus loin est un bourdonnement doux, moins de 70 cm est un bourdonnement très fort et tout le reste.

- Le capteur est également capable de vous dire si l'obstacle est droit devant, venant de la gauche ou de la droite.

- Pour ce faire, il ajoute un deuxième buzz haptique, en fonction de l'endroit où se trouve l'objet. Si l'obstacle est droit devant, il s'agit d'un simple bourdonnement répétitif, dont la force dépend de la distance à laquelle il se trouve.

- Si l'obstacle est à droite, un buzz de montée en puissance est ajouté après le buzz principal. Encore une fois, la force dépend de la distance à laquelle il est

- Si l'obstacle est à gauche, un buzz de rampe de descente est ajouté après le buzz principal

Simple!

Étape 11: Coder

Walabot Eye Github

DRV2605 GitHub

Conseillé:

Une application d'un bouton extensible avec retour de vibration : 7 étapes (avec photos)

Une application d'un bouton extensible avec retour de vibration : Dans ce tutoriel, nous allons d'abord vous montrer comment utiliser un Arduino Uno pour contrôler un moteur de vibration via un bouton étendu. La plupart des didacticiels sur les boutons-poussoirs impliquent le bouton de la maquette physique, alors que dans ce didacticiel, le bouton a été

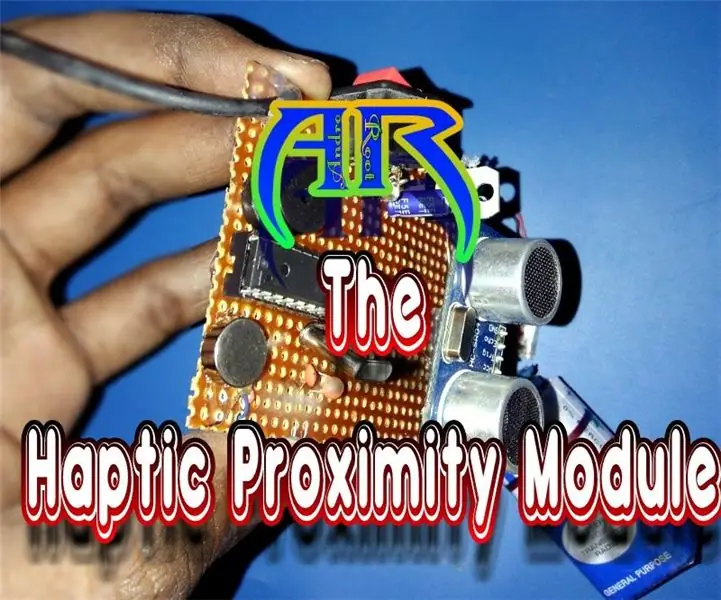

Module de proximité haptique - Pas cher et facile : 5 étapes (avec photos)

Module de proximité haptique - Pas cher et facile : Le sens de la vision que Dieu a donné à l'être humain est un aspect important de notre vie. Mais il y a des malheureux qui n'ont pas la capacité de visualiser les choses. Il y a environ 37 millions de personnes à travers le monde qui sont aveugles, plus de 15 milli

Robot de dessin haptique : 5 étapes (avec photos)

Robot de dessin haptique : Dans le cadre de mon diplôme de master au dep. Design industriel à l'Université d'Eindhoven, j'ai créé un dispositif de dessin haptique qui peut être utilisé pour diriger une voiture semi-autonome dans la circulation. L'interface s'appelle scribble et permet à l'utilisateur d'expérimenter

Détection visuelle d'objets avec une caméra (TfCD) : 15 étapes (avec photos)

Détection visuelle d'objets avec une caméra (TfCD) : Les services cognitifs capables de reconnaître des émotions, des visages de personnes ou des objets simples sont actuellement encore à un stade précoce de développement, mais avec l'apprentissage automatique, cette technologie se développe de plus en plus. Nous pouvons nous attendre à voir plus de cette magie dans

Comment faire un boomerang (le retour du robot avec le cerf-volant noir) : 8 étapes (avec photos)

Comment faire un boomerang (Le retour du robot avec le cerf-volant noir) : Je n'avais jamais fait de boomerang auparavant, alors j'ai pensé qu'il était temps. Il s'agit de deux projets de boomerang en un. Les instructions pour chacun sont remarquablement similaires, et vous pouvez suivre les différences dans les notes sur les images. Les boomerangs traditionnels ont deux