Table des matières:

- Auteur John Day day@howwhatproduce.com.

- Public 2024-01-30 09:07.

- Dernière modifié 2025-01-23 14:46.

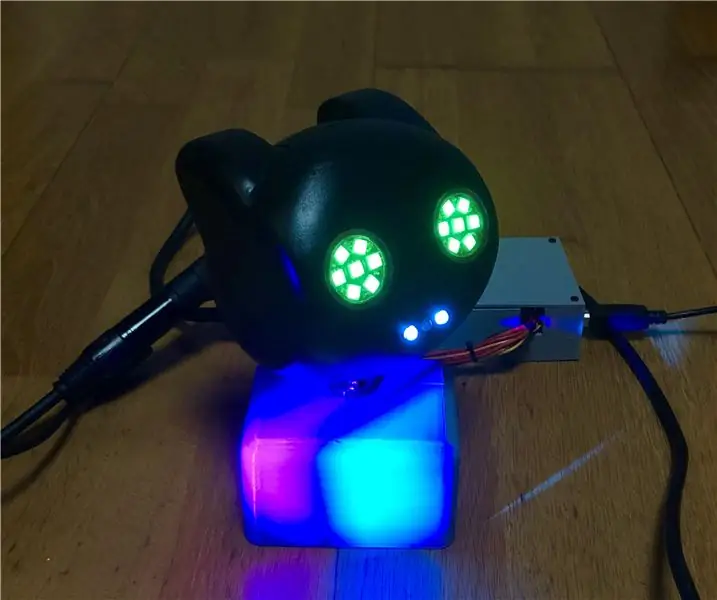

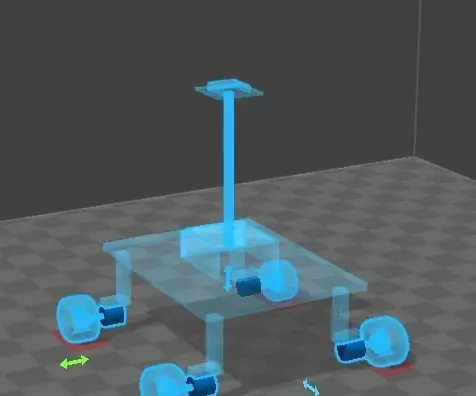

Mona, c'est un robot IA qui utilise watson Ai en arrière-plan, quand j'ai commencé ce projet, cela semble beaucoup plus compliqué que je ne le pensais, mais lorsque j'ai commencé à travailler dessus, les cours cognitifs d'ibm (inscrivez-vous ici) m'ont beaucoup aidé, si vous voulez, vous pouvez prenez le cours maintenant, ou bien continuez simplement avec ces instructables

j'ai besoin que mon bot réponde pour les choses suivantes

1. quand je parle

2. quand il veut parler

3.quand je veux contrôler les mouvements des yeux/de la mâchoire…etc.

ainsi, quand je parle, il doit convertir mon discours en texte, puis il doit vérifier dans la base de données (entités / événements /) puis il doit prononcer la réponse comme du texte à la parole.

donc vous avez besoin des choses ci-dessous

avant d'utiliser les services ci-dessous, veuillez créer un compte IBM Bluemix

1.texte à la parole

2. discours au texte

3. Watson assistant

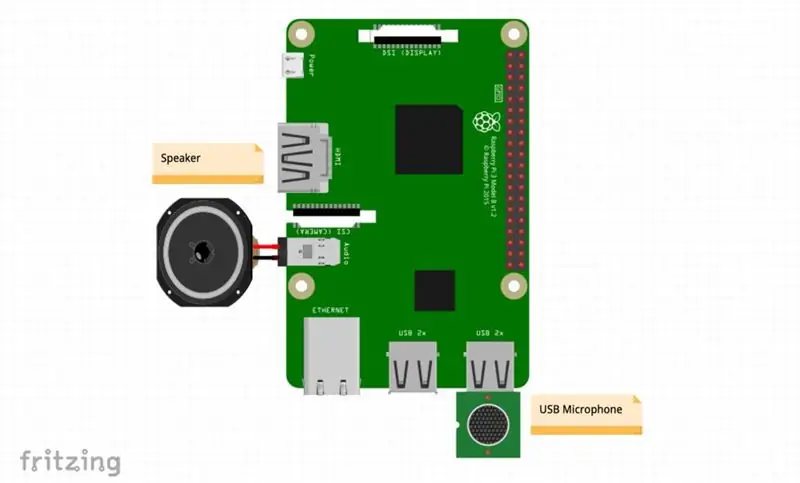

Étape 1: préparer vos affaires

1. Framboise Pi.

2. Micro

3. haut-parleur

Crâne (3d imprimé):

Fichiers d'impression 3D que vous pouvez trouver ici: cliquez ici

et surtout vous devez avoir une bonne connexion internet…………

Maintenant, je vais utiliser Raspberry Pi pour traiter le tout.

Si vous avez déjà utilisé Raspberry Pi, installez Node.js et passez à l'étape suivante.

Sinon, suivez les instructions ci-dessous pour configurer votre Pi:

Démarrer avec votre Pi Raspberry Pi est similaire à un ordinateur complet, ce qui signifie que vous avez besoin d'un moniteur, d'une souris et d'un clavier pour cela. Si vous avez un téléviseur à proximité, vous pouvez connecter votre Pi à votre téléviseur via un câble HDMI. Dans la plupart des kits Pi, la carte SD est déjà préchargée avec une image du système d'exploitation Raspberry Pi. Vous devez mettre la carte SD dans le Pi, allumer le Pi et suivre les instructions à l'écran pour terminer l'installation du système d'exploitation. Si vous rencontrez des problèmes pour configurer votre Pi, vous pouvez résoudre les problèmes ici.

Installer des packages Ouvrez une application de terminal sur le Pi et exécutez les commandes suivantes pour installer la dernière version de Node.js et npm (Node Package Manager).

Vous aurez besoin de ces packages plus tard pour exécuter votre code.

curl -sL https://ibm.biz/tjbot-bootstrap | sudo sh

Branchez votre microphone USB et le haut-parleur.

Selon la source de sortie audio que vous utilisez avec votre Pi (HDMI, prise audio 3,5 mm, Bluetooth, haut-parleur USB), vous devrez peut-être définir la configuration audio.

Prise audio HDMI/3,5 mm Si vous utilisez une prise audio HDMI ou 3,5 mm, vous devrez peut-être définir la configuration audio. Pour ce faire, allez dans le terminal et ouvrez raspi-config.

sudo raspi-config

Cela ouvrira l'écran de configuration du Raspberry Pi.

Sélectionnez « Options avancées » et appuyez sur Entrée, puis sélectionnez « Audio » et appuyez sur Entrée. Choisissez le bon canal pour l'audio de sortie. Si vous avez connecté un haut-parleur externe à la prise audio, vous devez sélectionner la prise 3,5 mm.

Haut-parleur USB:

Si vous avez un audio USB, vous devez mettre à jour votre /usr/share/alsa/alsa.config pour définir l'audio USB comme périphérique par défaut. Commencez par exécuter la commande suivante pour vous assurer que votre clé USB est connectée et répertoriée ici.

lsusb

Ensuite, il faut détecter le numéro de carte de votre USB audio.aplay -l

Notez le numéro de carte associé à votre USB Audio.

Accédez ensuite au fichier alsa.config pour le définir par défaut.

sudo nano /usr/share/alsa/alsa.conf

Chercher

defaults.ctl.card 0

defaults.pcm.card 0

et mettez à jour le numéro de carte (0 ici) avec le numéro de carte de votre audio USB.

Différentes versions de Raspberry Pi OS peuvent nécessiter une configuration différente. Si vous rencontrez des problèmes avec votre configuration USB, consultez ce guide pour résoudre les problèmes.

Étape 2: Code Git-hub

Le code source est disponible sur github. Téléchargez ou clonez le code et exécutez les commandes suivantes à partir d'un terminal pour installer ses dépendances. Voici les instructions pour cloner un référentiel à partir de github si vous ne l'avez pas déjà fait.

git clone

cd mona/recettes/conversation

npm installer

Conseil de pro: si vous obtenez une erreur pour l'installation de npm indiquant que npm est introuvable, vous devez d'abord installer npm sur votre machine. Ceci est la ligne de commande pour installer npm

sudo apt-get install npm

Dans cette étape, nous vous aidons à obtenir un accès API à trois services de conversation:

(1) Parole en texte, (2) Assistant Watson, (3) Text to Speech.

Vous devez copier vos informations d'identification pour tous ces services. Créez des instances des services Watson Assistant, Speech to Text et Text to Speech et notez les informations d'identification.

Importez le workspace-sample.json

dans le service Watson Assistant et notez l'ID de l'espace de travail.

Faites une copie du fichier de configuration par défaut et mettez-le à jour avec les informations d'identification du service Watson et l'ID de l'espace de travail de conversation.

$ sudo cp config.default.js config.js

$ sudo nano config.js

Étape 3: Exécutez le code

Maintenant, vous êtes prêt à parler à votre TJBot !

Ouvrez un terminal et exécutez la commande suivante:

conversation de nœud sudo.js

La conversation Watson utilise des intentions pour étiqueter le but d'une phrase.

Par exemple, lorsque vous demandez à Mona « Veuillez vous présenter », l'intention est de faire une introduction.

Vous pouvez ajouter vos propres intentions dans l'éditeur de conversation, mais pour l'instant, nous vous avons commencé avec quelques intentions: Introduction.

Vous pouvez dire des phrases telles que "Watson, présentez-vous s'il vous plaît", "Watson, qui êtes-vous" et "Watson, pouvez-vous vous présenter" Blague.

Vous pouvez demander « Watson, s'il vous plaît, racontez-moi une blague » ou « Watson, j'aimerais entendre une blague ».

Pour une liste complète, vérifiez le contenu de workspace-sample.json

Un mot d'attention est utilisé pour que Mona sache que vous lui parlez.

Le mot d'attention par défaut est « Watson », mais vous pouvez le modifier dans config.js comme suit.

Mettez à jour le fichier de configuration pour changer le nom du robot dans la section tjConfig: // configurez la configuration de TJBot

exportations.tjConfig = {

log: { niveau: 'verbose' },

robot: { nom: 'tee jay bot' }

};

Vous pouvez changer le 'nom' comme vous voulez appeler votre "Mona". De plus, si vous changez le genre en 'femelle', TJBot utilisera une voix féminine pour vous parler ! Prendre plaisir!

il y a de fortes chances que l'une de ces deux choses se soit produite: (1) La sortie audio est dirigée vers un mauvais canal (vous pouvez le réparer depuis raspi-config), (2) vos modules de sons sont bloqués.

Dans ce cas, allez dans /etc/modprobe.d/ et supprimez blacklist-rgb-led.conf Puis exécutez la commande suivante:

sudo update-initramfs -u

Redémarrez et confirmez que les modules "snd" sont en cours d'exécution en exécutant la commande "lsmod".

Cela devrait résoudre le problème. lsmod

Conseillé:

Robot animatronique DMX : 9 étapes (avec photos)

Robot animatronique DMX : Ce projet décrit le développement d'un prototype animatronique entièrement fonctionnel. Il est implémenté à partir de zéro et vise à être un guide pour le développement de futurs robots animatroniques plus complexes. Le système est basé sur un microcontrôleur Arduino

Assistant personnel - Intellect Machine : 7 étapes

Assistant personnel - Intellect Machine : Dans le monde trépidant d'aujourd'hui, on n'a pas suffisamment de temps pour rester en contact avec le monde extérieur et social. On peut ne pas avoir assez de temps pour obtenir des mises à jour quotidiennes concernant l'actualité ainsi que le monde social comme facebook ou gmail.One

Assistant personnel basé sur Arduino. (BHAI) : 4 étapes

Assistant personnel basé sur Arduino. (BHAI) : Introduction : Fabriqué en collaboration avec Kundan Singh ThakurThis est mon premier instructable donc s'il vous plaît plier avec toutes les erreurs que j'ai pu faire. Laissez également des commentaires en cas de doute ou de problème. L'assistant personnel basé sur Arduino est comme votre vir

Assistant personnel : 9 étapes (avec photos)

Assistant personnel : dans cette instructable, je vais vous montrer comment vous pouvez utiliser la puissance de l'ESP8266, la créativité dans la conception et la programmation de logiciels, pour créer quelque chose de cool et éducatif. Je l'ai nommé Assistant personnel, car il est de poche, parle à vous, et peut donner

SEER - Assistant personnel intelligent basé sur InternetOfThings : 12 étapes (avec photos)

SEER - Assistant personnel intelligent basé sur InternetOfThings : Seer est un appareil qui jouera un rôle de rappel dans le domaine des maisons intelligentes et de l'automatisation. Il s'agit essentiellement d'une application de l'Internet des objets. du Raspberry Pi 3 modèle B avec une caméra intégrée